客服热线:010-62958599

H200是首款搭载HBM3e显存的GPU,显存容量达到141GB,显存带宽高达每秒4.8TB,相较于H100的3.35TB/s提升了1.4倍

内存技术,搭载 141GB HBM3e内存,带宽高达 4.8TB/s

第四代张量核心,与 H100 相同的第四代张量核心技术,支持更高效的深度学习和推理

安全多实例GPU(MIG)

第四代 NVLink,提供高达 900GB/s 的双向带宽

推理性能,在处理如 Llama2 70B 等大语言模型时,推理性能是 H100 的 2 倍

支持PCle5.0和NVLink8.0,数据传输速度高达128GB/s和800GB/s

从Ampere到Hopper的跨越

第四代Tensor Core与FP8革命

机密计算与能效优化

性能提升与应用场景

NVIDIA L40S GPU 是一款适用于数据中心的功能强大的通用型 GPU,可为下一代 AI 应用提供端到端加速服务 ‒ 从生成式 AI 以及模型训练和推理到 3D 图形、渲染和视 频应用。

第四代 Tensor Core

第三代 RT Core

Transformer 引擎

数据中心就绪

24 GB GDDR6,最大72 W,支持通过PCIe Gen4 x16插槽供电,无需额外电源线

第三代 RT Core

第四代 Tensor Core

先进的视频和视觉 AI 加 速

深度学习超级采样 (DLSS)

虚拟化就绪

数据中心效率和安全性

NVIDIA L20 是双插槽全高全长PCIe扩展卡,搭载96MB二级缓存、48GB GDDR6 ECC内存,带宽864GB/s,INT8/FP8算力为239T

高性能

低功耗

广泛的应用场景

先进的AI加速功能

高性价比

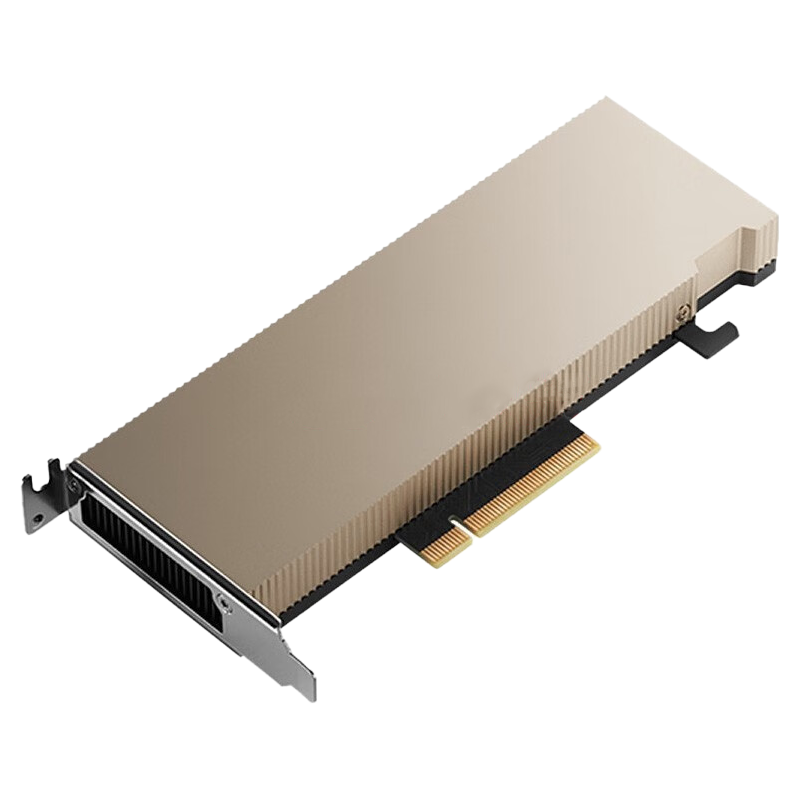

NVIDIA A2 Tensor Core GPU 具有低功耗、小尺寸和高性能的特点,可为在边缘部署 NVIDIA AI 的智能视频分析 (IVA) 提供入门级推理功能

推理性能提升高达 20 倍

在智能边缘实现更高的 IVA 性能

针对服务器进行优化

领先的跨云、数据中心和边缘的 AI 推理性能

已为企业使用做好准备

主流 NVIDIA 认证系统

NVIDIA A10 GPU小型的单插槽 150W GPU 与 NVIDIA 虚拟化 GPU (vGPU) 软件结合使用时,可在易于管理、安全且有弹性

专业功能

远程协作

企业级

3D 可视化

人工智能加速应用程序

交互式渲染技术

NVIDIA A16它结合了 NVIDIA 虚拟 PC (vPC) 或 NVIDIA RTX 虚拟工作站 (vWS) 软件,使虚拟桌面和工作站具有强大的功能和性能,可以随时随地处理各种项目

专为加速虚拟桌面架构打造

经济实惠的虚拟工作站

高分辨率显示器

编码器吞吐量提高 2 倍以上

更高质量的视频

PCI Express 第 4 代

NVIDIA Ampere 架构