客服热线:010-62958599

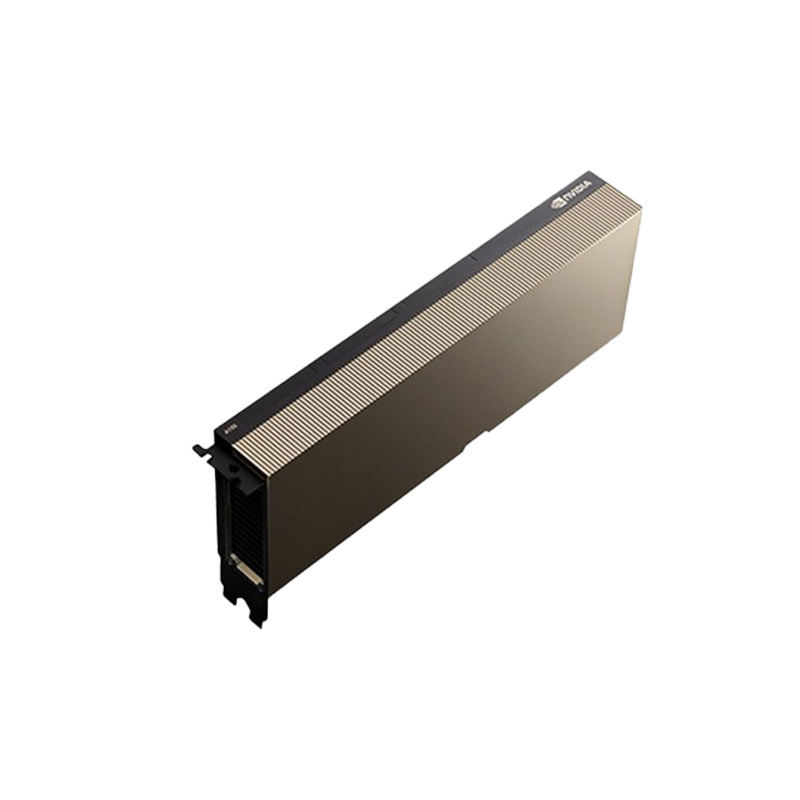

型号:NVIDIA H200 GPU

内存技术,搭载 141GB HBM3e内存,带宽高达 4.8TB/s

第四代张量核心,与 H100 相同的第四代张量核心技术,支持更高效的深度学习和推理

安全多实例GPU(MIG)

第四代 NVLink,提供高达 900GB/s 的双向带宽

推理性能,在处理如 Llama2 70B 等大语言模型时,推理性能是 H100 的 2 倍

NVIDIA H200 Tensor核心GPU是基于Hopper架构的最新一代高性能计算和生成式人工智能加速器,专为处理复杂的AI推理和高性能计算(HPC)任务而设计。

品牌 | NVIDIA英伟达 | 型号 | H200 141GB SXM |

货号 | H200 141GB SXM | 产品尺寸 | 268mmX111mm双槽 |

芯片厂方 | NVIDIA | 芯片型号 | H200 141GB SXM |

接口 | PCIe | 显存容量 | 141GB |

核心位宽 | 5120bit | 显卡插槽 | PCIe 5.0 x16 |

显存类型 | HBM2e/3 | 显存位宽 | 6144-bit |

核心频率 | 1000MHz(MHz) | 显存频率 | 1593MHz(MHz) |

流处理器单元 | 14592(个) | 3D API | DirectX 12 |

显存与带宽

H200是首款搭载HBM3e显存的GPU,显存容量达到141GB,显存带宽高达每秒4.8TB,相较于H100的3.35TB/s提升了1.4倍。这种更大的显存容量和更快的带宽显著加速了生成式AI和高性能计算任务的数据处理能力。

高性能计算(HPC)加速

H200在科学计算和模拟任务中表现出色,其高达110倍的性能提升(相较于传统CPU)得益于更高的显存带宽和优化的计算架构。这使其在内存密集型应用(如科学研究和模拟)中具有显著优势。

能效与成本优化

H200在提供卓越性能的同时保持了与H100相同的功耗设置(最高700W),但其能源效率更高,总体拥有成本(TCO)更低。这使其在AI工厂和超级计算系统中不仅更快速,还更环保。

适用场景

H200适用于生成式AI、科学计算、企业AI推理等多种场景,并支持NVIDIA AI Enterprise软件,简化AI开发和部署流程。